NEWSLETTER ABONNIEREN

Sie interessieren sich für die Projekte und Ergebnisse unserer Zukunftslabore? Unser Newsletter fasst die wichtigsten Ereignisse alle zwei Monate zusammen.

Jetzt anmeldenProduktionsketten bestehen oftmals über mehrere Standorte und mehrere Unternehmen hinweg. Bei der Aluminiumdruckgussproduktion arbeiten viele Unternehmen Hand in Hand – von der Herstellung der Aluminiumgießform bis zur Zerspanung des fertigen Bauteils sind in der Regel verschiedene Betriebe beteiligt. Das Zukunftslabor Produktion untersucht diese beispielhafte Lieferkette, um die Möglichkeiten digitaler Innovationen für die Optimierung der Prozesse zu erforschen.

Zentrale Grundlage für die Verbesserung einzelner Produktionsschritte sind Daten, die während des Fertigungsprozesses erhoben und analysiert werden. Unternehmen teilen ihre Daten ungern – aus Sorge vor Wettbewerbsnachteilen, Datendiebstahl oder dem Verlust geistigen Eigentums. Die unternehmensübergreifende Datenanalyse bietet aber einen großen Mehrwert in der Optimierung der Produktion. Daher entwickeln die Wissenschaftler*innen des Zukunftslabors eine Plattform, die die Privatsphäre und die Dateneigentumsinteressen der Unternehmen ausreichend schützt und trotzdem eine unternehmensübergreifende Datenanalyse ermöglicht.

Szenario für den Datenaustausch

Die Wissenschaftler*innen bestimmten ein Szenario, welches sie für die Anwendung der Datenplattform zugrunde legen: Das Szenario beinhaltet die gemeinschaftliche Analyse von Daten aus dem Werkzeugbau und der Fertigung im Druckguss. Hierbei geht es darum herauszufinden, weshalb manche Bauteile nicht der gewünschten Qualität entsprechen. Auf Basis der Daten soll eine Prognose erstellt werden, ob die mangelhafte Qualität aufgrund eines Werkzeugfehlers entstanden ist, oder ob andere Ursachen verantwortlich sind. Mithilfe der Datenplattform wollen die Wissenschaftler*innen auch ermitteln, wie wahrscheinlich es ist, dass das Gießwerkzeug während des Gießprozesses ausfällt.

Testversion und Sicherheitsaspekte der Datenplattform

Den Wissenschaftler*innen des Zukunftslabors ist es wichtig, die Datenplattform anwendungsorientiert zu gestalten, also so, dass sie den Ansprüchen der Wirtschaft gerecht wird. Deshalb erstellten sie in Zusammenarbeit mit Praxispartnern ein Minimal-Viable-Produkt (MVP) der Datenplattform. Dabei handelt es sich um eine funktionsfähige Testversion. Diese Testversion stellten die Wissenschaftler*innen einigen Praxispartnern zur Verfügung und holten sich Feedback ein. Auf Basis des Feedbacks nahmen die Wissenschaftler*innen Anpassungen an der Plattform vor. Außerdem nutzten sie das MVP, um selbst einige Funktionen der Plattform zu prüfen.

Besonderen Wert legen die Wissenschaftler*innen auf die Sicherheit der Plattform. Deshalb orientieren sie sich bei ihrer Forschung an der Industrienorm IEC62443-3-3, die technische Anforderungen für die IT-Sicherheit von Systemen beschreibt. In diesem Zusammenhang prüften sie, welche Anforderungen die Datenplattform laut der Norm erfüllen muss und definierten entsprechende Umsetzungsmaßnahmen. Insgesamt muss die Datenplattform rund 50 Anforderungen berücksichtigen (z. B. Identifizierung und Authentifizierung, Vertraulichkeit der Daten, Reaktion auf Ereignisse).

Um zu prüfen, ob das MVP allgemeinen IT-Sicherheitskriterien entspricht, führten die Wissenschaftler*innen eine Risikoanalyse durch. Sie testeten u. a., ob das MVP unberechtigten Zugriffen von außen standhält und ob die gängigen Regeln zur Vertraulichkeit korrekt umgesetzt werden. Damit eine digitale Plattform allgemeinen sicherheitstechnischen Anforderungen entspricht, sollte sie einen ganzheitlichen Sicherheitsansatz verfolgen. Dieser umfasst sowohl präventive als auch reaktive Maßnahmen. Die Risikoanalyse wiederholt sich zyklisch bei jedem großen Update des Systems.

Das MVP basiert auf dem Jade-Framework. Ein Framework ist die Grundstruktur und das Gerüst für die Programmierung von Software. In der Datenplattform ist es dafür zuständig, die Dienste zu verknüpfen, welche die Daten der verschiedenen Unternehmen analysieren. Durch die Tests stellten die Wissenschaftler*innen fest, dass das Jade-Framework nicht mehr State of the Art ist, weil z. B. für zentrale IT-Sicherheitsaspekte keine Aktualisierungen mehr verfügbar sind.

Deshalb beschlossen sie, für die Verknüpfung der Analyse-Dienste ein anderes Framework zu nutzen: Spring Boot. Dieses Framework basiert auf Microservices. Das sind kleine, unabhängige Dienste, die über Schnittstellen miteinander kommunizieren. Microservices sind einfach zu skalieren und verkürzen die Entwicklungszeit von Anwendungen. Dadurch eignen sie sich besonders für innovative Ideen und reduzieren die Markteinführungszeit neuer Funktionen. Um die Microservices leichter verwalten zu können, bauten die Wissenschaftler*innen eine Container-Umgebung auf. Container sind virtuelle Behälter – ähnlich wie Frachtcontainer, die in der Spedition eingesetzt werden. Container ermöglichen es, die Microservices in unterschiedlichen Server-Umgebungen zu entwickeln und zu testen.

Eine Containerumgebung ist eine virtualisierte Plattform, die es ermöglicht, Anwendungen und deren Abhängigkeiten in isolierten, leichtgewichtigen Containern auszuführen. Diese Container sind Einheiten, die in verschiedenen Umgebungen konsistent laufen können und die Bereitstellung von Software beschleunigen und vereinfachen.

Ein weiterer Vorteil von Springt Boot besteht darin, dass dieses Framework bereits einigen Sicherheitsstandards entspricht, sodass es die Gestaltung der Sicherheitsumgebung vereinfacht.

Anpassungen an der Datenplattform

Für den unternehmensübergreifenden Austausch von Daten entwickelten die Wissenschaftler*innen eine Connector-Funktion. Ein Connector ist der zentrale Knotenpunkt, über den die unternehmensinternen Datenplattformen aggregiert werden. Damit werden auch andere Dienste angebunden, wie z. B. Sicherheitszertifikate oder User-Logins. Ein wichtiger Aspekt dabei ist, dass die Daten nicht auf der Plattform selbst gespeichert, sondern über den Connector analysierbar sind. Die Daten bleiben also weiterhin ausschließlich auf den Servern der Unternehmen gespeichert. Demnach sichert die Funktionsweise des Connectors das geistige Eigentum der beteiligten Unternehmen technisch vor unberechtigten Zugriffen ab.

Dies wird über Federated Learning (FL) realisiert. FL ist eine Technik des Maschinellen Lernens, bei der die Daten nicht auf einem einzigen Server analysiert werden, sondern auf Servern der einzelnen Partner. Das Verfahren analysiert die Daten somit dezentral und tauscht in mehreren Schritten die entwickelten Modelle und Parameter aus. Die zusammengesetzten Modelle werden zentral aggregiert. Mittels Verfahren der partiellen Privatsphäre kann die Datensouveränität zusätzlich erhöht werden. Diese Technik ermöglicht also eine Datenanalyse, ohne dass sensible Daten offengelegt werden müssen und die Privatsphäre verletzt wird. Voraussetzung ist auch hier, dass die entsprechenden Sicherheits- und Datenschutzvorkehrungen eingestellt werden.

Dementsprechend schützt das entwickelte Architekturmodell die Datensouveränität auf technische Weise. Dies wurde in Zusammenarbeit mit einer Rechtsanwaltskanzlei evaluiert und bestätigt. Gemeinsam mit der Kanzlei diskutierten die Wissenschaftler*innen Optionen, diese Datensouveränität weiter zu verbessern. Dies ist z. B. möglich, indem die Plattform durch einen unabhängigen Dritten bereitgestellt wird. Der Vorteil besteht darin, dass eine unabhängige Partei keinen Nutzen aus dem Missbrauch der Plattform ziehen würde und somit das Risiko einer Manipulation oder Ausnutzung von möglichen, aktuell noch unbekannten Schwachstellen reduziert wird.

Neben dem Connector programmierten die Wissenschaftler*innen eine Webapplication zur Verknüpfung der Datenbestände und entwickelten eine Unterstützungssoftware zur Integration von Datenbeständen. Dies ist wichtig, da die Unternehmen über verschiedene Datenquellen verfügen (z. B. aus Produktionsanlagen, ERP-Systemen, der Anlagensteuerung). Diese Datenquellen bilden Datensilos, die nicht miteinander verknüpft sind. Die Datenverknüpfung ist aber Voraussetzung für die Datenplattform des Zukunftslabors, die eine Optimierung sämtlicher Produktionsschritte aller beteiligten Unternehmen der Lieferkette zum Ziel hat. Die Unterstützungssoftware hilft dabei, die Datenpunkte innerhalb eines Unternehmens zu identifizieren und sie in eine Datenbank zu überführen, die zwischen der eigentlichen Datenquelle und der Datenplattform des Zukunftslabors geschaltet ist. Die Software unterstützt die Unternehmen also dabei, die eigenen Datenbestände aus den einzelnen Silos zusammenzuführen und somit die Voraussetzung für die Anwendung von Analysealgorithmen zu schaffen.

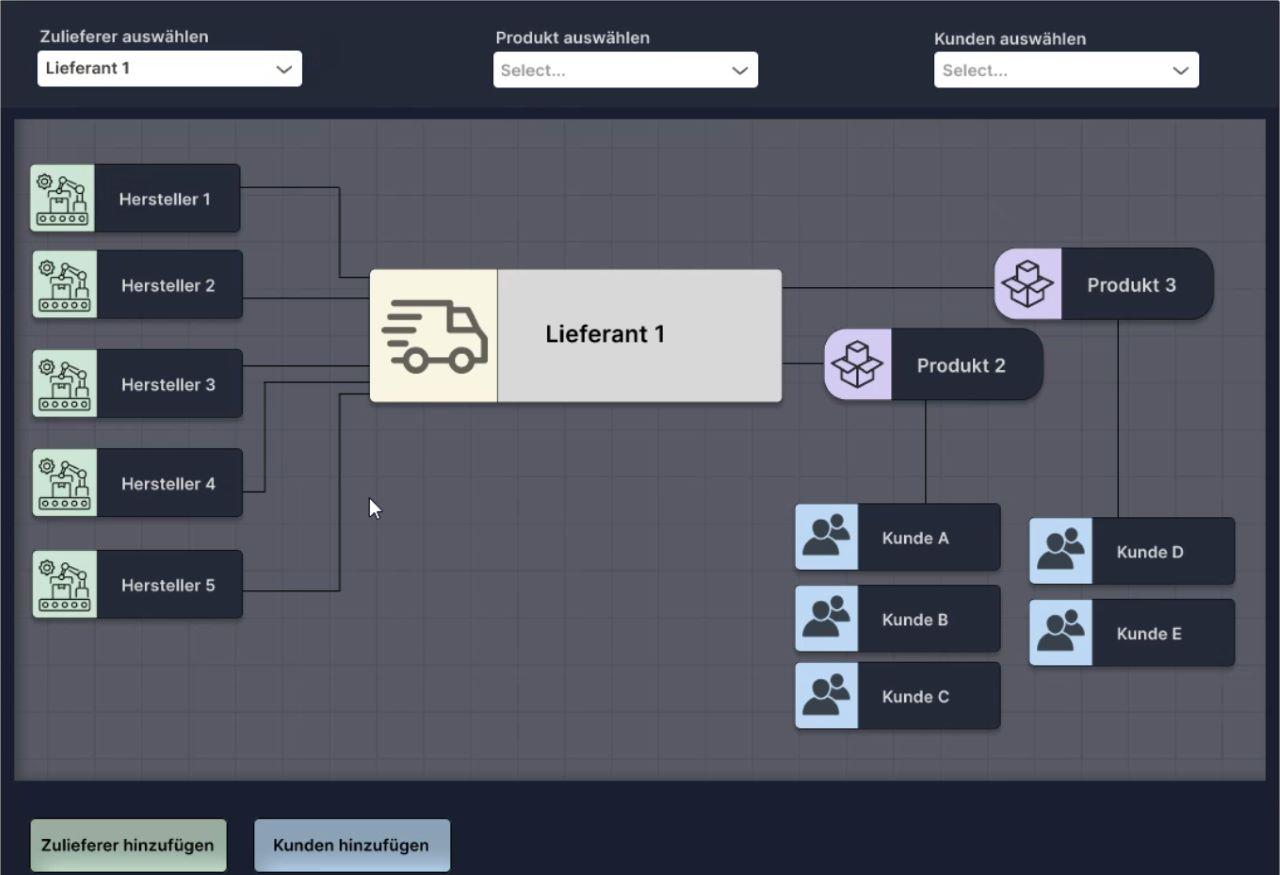

Die Webapplication verknüpft die Datenquellen aller beteiligten Unternehmen entlang der Lieferkette. Über die Webapplication werden die realen Beziehungen der Unternehmen abgebildet, sodass die Verknüpfung der Beteiligten sichtbar wird. Damit werden die Unternehmen in die Lage versetzt, die Lieferkettenabhängigkeiten (Zulieferer/Kunde) mit den intern gelagerten Datenbeständen zu koppeln. Ziel ist es, die getrennten Datenquellen der Unternehmen verknüpfbar zu machen, um die nachfolgenden Analysemodelle austauschen zu können. Daraus resultiert der gemeinsame Nutzenwert für den unternehmensübergreifenden Produktionsablauf.

Darüber hinaus entwickelten die Wissenschaftler*innen Benutzeroberflächen für die Plattform und einfache Elemente wie ein Nutzerlogin oder das Backend für die Datenbank. In der Benutzeroberfläche sollen auch die Beziehungen der Unternehmen entlang der Lieferkette visualisiert werden. Daran werden die Wissenschaftler*innen noch weiterarbeiten. Das Konzept der Datenplattform soll auch auf andere Lieferketten übertragen werden können.

Aufbau eines Demonstrators zur Darstellung der Lieferkette

Die Wissenschaftler*innen arbeiten an einem Demonstrator, der die Vernetzung der Lieferkette abbilden soll. Es handelt sich um eine transportierbare Holzplatte, auf der eine Miniaturfabrik zu sehen ist. Diese Fabrik enthält eine CNC-Fräse mit Ritzaufsatz. Die Fabrik ist über eine Eisenbahn ans Transportwesen angebunden, das Daten über Auslastung und Geschwindigkeit erheben kann. Über die Eisenbahn wird ein Holzstück in die Fabrik geliefert. Dieses Holzstück wird mithilfe der Fräsmaschine graviert. Zusätzlich werden über einen Scanner die Kontaktinformationen einer haptischen Visitenkarte erfasst und in eine virtuelle Visitenkarte überführt. Die Daten aus der virtuellen Visitenkarte werden auf einen Chip übertragen, der sich in dem Holzstück befindet. Über ein Lesegerät können die Daten wie bei einer Bankkarte ausgelesen werden.

Unser Demonstrator stellt verschiedene Prozessschritte dar, wie z. B. Transport, Verarbeitung und Datenerfassung. Er veranschaulicht auf einfache Weise eine Lieferkette, an der mehrere Unternehmen beteiligt sind. Wir planen auch, eine Qualitätsprüfung des Endproduktes in den Demonstrator zu integrieren. Zudem werden wir ein föderiertes Lernmodell implementieren, das auf der Basis möglicher Qualitätsabweichungen die Lebensdauer und den Zustand des Produktes bewerten kann. 2024 wollen wir den Demonstrator auf Messen und Veranstaltungen einsetzen, um Interessent*innen einen anschaulichen Einblick in unsere Forschung zu geben.

Ausblick 2024

Im Forschungsjahr 2024 werden die Wissenschaftler*innen die Daten aus dem Druckgießprozess über ein Edge Device an die Plattform anbinden. Ein Edge Device ist ein Gerät, das die Daten einer Anlage bündelt und voranalysiert. Zudem werden sie den Connector in die Datenplattform integrieren und Schnittstellen zu den Nutzern – also den Unternehmen, die an der Lieferkette beteiligt sind – herstellen. Außerdem werden sie weitere Sicherheitsmaßnahmen und die allgemeine Funktionalität der Plattform testen. Darüber hinaus ist geplant, die Plattform in zwei Anwendungsszenarien bzw. Lieferketten umzusetzen: Neben dem Aluminiumdruckguss soll die Plattform auch in einer Lieferkette des Kunststoffspritzgusses eingesetzt werden.

Des Weiteren werden die Wissenschaftler*innen den Demonstrator ausbauen. Sie werden im Show Room in Emden eine Arbeitsstation mit Lasergravierer integrieren. Außerdem planen sie, den Demonstrator um eine digitale Wertschöpfungsstufe zu erweitern, und zwar, indem ein Datenpaket und Informationsmaterial des Zukunftslabors per E-Mail an den Inhaber/die Inhaberin der Visitenkarte verschickt wird. Darüber hinaus werden die Wissenschaftler*innen den Ausfall von Transportsystemen simulieren und Sensorik zur frühzeitigen Fehlererkennung einbauen. Um das System noch sicherer zu gestalten, folgen weitere Optimierungsmaßnahmen und Qualitätstests.