NEWSLETTER ABONNIEREN

Sie interessieren sich für die Projekte und Ergebnisse unserer Zukunftslabore? Unser Newsletter fasst die wichtigsten Ereignisse alle zwei Monate zusammen.

Jetzt anmeldenAn der Produktion eines industriellen Bauteils sind unterschiedliche Akteure beteiligt. Am Beispiel der Druckgussindustrie, die in Niedersachsen Teile für die Automobilindustrie, die Medizintechnik sowie für die Luft- und Raumfahrt herstellt, wird die Prozesskette deutlich: Der Prozess beginnt bei den Kund*innen, die ihre Anforderungen hinsichtlich der benötigten Bauteile der Gießerei mitteilen. Daraufhin beginnt die Gießerei mit der Produktionsplanung. Dazu gehört unter anderem die Herstellung des Formwerkzeuges, mit dem die Bauteile gegossen werden. Die Herstellung der Form und das Gießen der Bauteile finden häufig an unterschiedlichen Standorten und in verschiedenen Unternehmen statt, da der Formen- und Werkzeugbau üblicherweise fremdvergeben wird. Nach erfolgreicher Fertigung des Formwerkzeuges und Produktion der bestellten Bauteile werden diese den Kund*innen ausgeliefert. Während der einzelnen Schritte entstehen zahlreiche Daten in der Prozesskette, die bisher in den meisten Fällen nur intern in den Unternehmen verwendet werden. Der Datenaustausch zwischen den Standorten und den Unternehmen kann aber einen Mehrwert für die Wertschöpfung bieten. Dies wird jedoch meistens nicht genutzt, aus Angst vor Wettbewerbsnachteilen. Deshalb befasst sich das Zukunftslabor Produktion mit der Frage, wie die digitale Kette der einzelnen Akteure geschlossen werden kann.

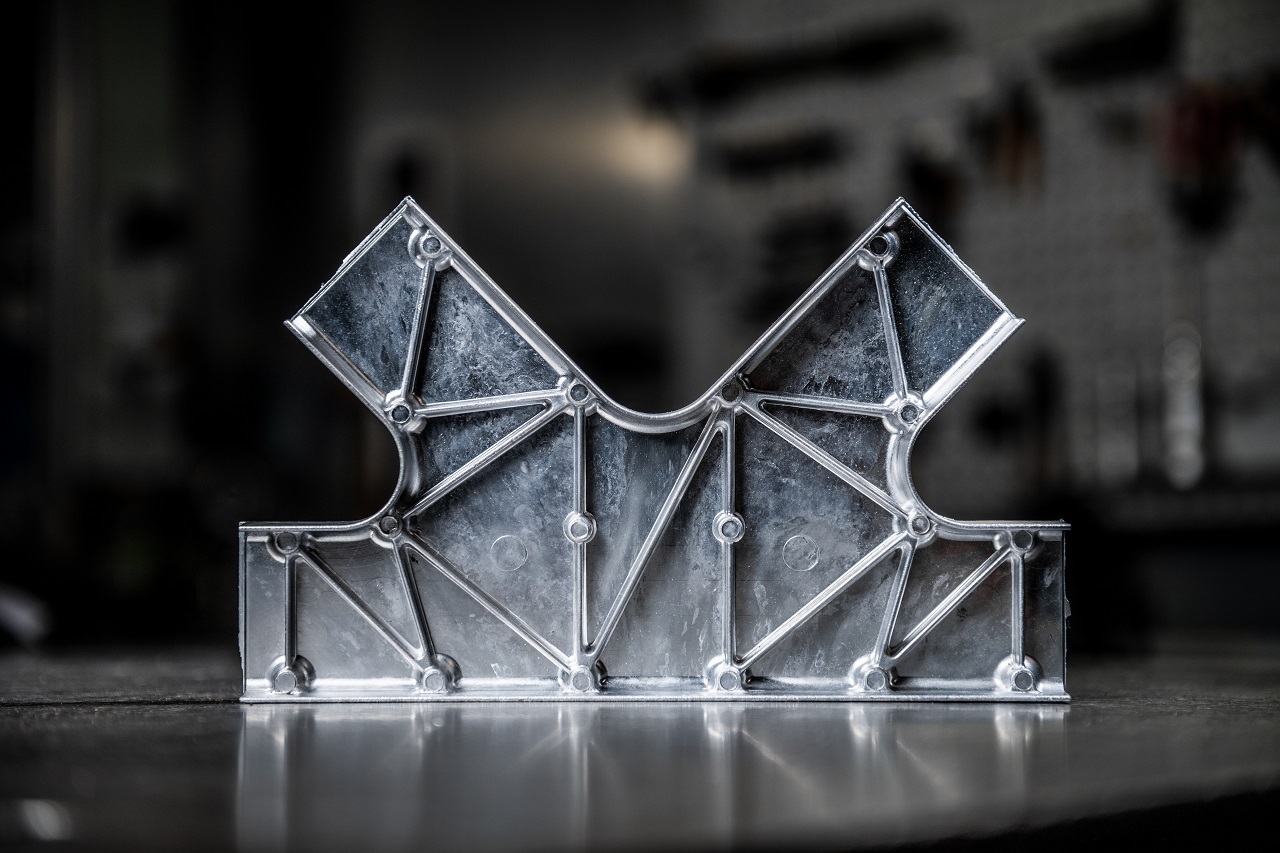

Die Wissenschaftler*innen des Zukunftslabors beginnen bei der Druckgießerei. Nachdem der Kunde bzw. die Kundin die Bauteilgeometrie und das gewünschte Auftragsvolumen übermittelt hat, wird ein Formwerkzeug angefertigt. Für die Erzeugung realer Prozessdaten arbeiten die Wissenschaftler*innen mit einem Referenzbauteil, das für die gesamten Forschungstätigkeiten als Beispiel dient. Zunächst war geplant, die Trägerstruktur für einen Flugzeugtisch als Referenzbauteil zu verwenden. Aus wirtschaftlichen Gründen entschieden sich die Wissenschaftler*innen jedoch dazu, ein anderes Bauteil zu wählen: Sie arbeiten nun mit dem Strukturbauteil „Knotenelement“, mithilfe dessen z. B. mehrere Strangpressprofile verbunden werden können. Dies spart Kosten und Zeit gegenüber dem ursprünglich geplanten Bauteil, für das die Wissenschaftler*innen zunächst die Gießform hätten fertigen müssen.

Intelligente Werkzeugsysteme liefern Daten für automatisierte Qualitätsprognosen

Beim Druckgießprozess gibt es zahlreiche messbare Größen, die sich bedeutend auf die Qualität der Bauteile auswirken wie z. B. Temperatur, Druck oder Volumenstrom. Um zu erkennen, wie sich diese physikalischen Größen gegenseitig beeinflussen und welche Auswirkungen sie auf die Bauteilqualität haben, simulierten die Wissenschaftler*innen den Gießvorgang und führten eine virtuelle Sensitivitätsanalyse durch. Bei einer solchen Analyse wird bewertet, wie empfindlich Qualitätsmerkmale auf kleine Änderungen von Eingangsparametern reagieren. Im Kontext des Zukunftslabors prüften die Wissenschaftler*innen, wie sich die Eigenschaften des Gussteils verändern, wenn die eingestellten Produktionsparameter an der Druckgießanlage durch äußere oder anlagenbedingte Einflüsse schwanken. Als Ergebnis entsteht jeweils für die Kombination der gewählten Eingangsparameter ein virtuell gegossenes Bauteil. Auf dieser Basis kann anhand der Eingangsparameter die Qualität des Gussteils prognostiziert werden. Dies ist nützlich, um auf Basis der Vorhersage der Bauteilqualität mögliche Optimierungsmaßnahmen zu identifizieren.

Anhand eines Beispieldatensatzes eines assoziierten Praxispartners aus einer realen Druckgießserie und der anschließenden bauteilbezogenen Qualitätsprüfung von über 8.000 Gussteilen konnten die Wissenschaftler*innen die Bauteilqualität auf Zusammenhänge mit den Prozessdaten prüfen sowie die Genauigkeit derartiger Prognosen bestimmen. Dafür führten sie eine Regressionsanalyse durch: ein statistisches Verfahren, das die Beziehung zwischen einer abhängigen und einer oder mehreren unabhängigen Variablen modelliert. Die Prognose der zu erwartenden Bauteilqualität ist nur mithilfe von Daten möglich, die Informationen über den Gießprozess liefern. Beispielsweise verfügt die Druckgießanlage in der Gießeinheit über mehrere Sensoren, die zyklusbezogen den Kolbenweg und Kolbendruck über die Zeit erfassen. Diese und einige weitere Prozessdaten, die mithilfe der vom Werk vorhandener Sensorik erfasst werden, können dann aus der Druckgießanlage als ein Datensatz exportiert und für Analysen verwendet werden. Um ein möglichst präzises digitales Abbild des realen Druckgießprozesses zu erzeugen, werden weitere Sensoren in das Formwerkzeug, an die Druckgießmaschine und Peripheriegeräte wie die Luftevakuierungseinheit (sog. Vakuumanlage), Schmelzofen, Heiz- und Kühlgeräte (sog. Temperiergeräte) sowie Trenn- und Schmierstoffversorgung integriert. Der Umfang dieser zusätzlichen Sensorik wird auf Basis der Fachkenntnisse und über die Gießsimulation bestimmt. Um Sensoren anforderungsgerecht integrieren zu können, erstellten die Wissenschaftler*innen zunächst eine Übersicht zu physikalischen Messgrößen, geforderten Messfrequenz und Kommunikationsform der geplanten Sensoren. Zuerst integrierten sie vier Piezokeramische-Kraftsensoren zur Erfassung der Auswerferkraft und des Forminnendruckes sowie vier Multitiefentemperatursensoren zur Erfassung der Temperatur in unterschiedlichen Tiefen der Form. Eines der Hauptziele im weiteren Verlauf des Projektes ist es, geplante Sensorik im Prozessumfeld Schritt für Schritt vollständig zu integrieren und diese in die Datenanalyse einzubinden. Bei der Aufzeichnung der Sensordaten stehen die Wissenschaftler*innen vor der Herausforderung, die Daten an den verschiedenen Stellen lückenlos möglichst in Echtzeit und teilweise mit hohen Frequenzen zu erfassen und die Datenströme zu einem konsistenten Gesamtdatensatz zusammenzufügen.

Im nächsten Schritt werden wir die Druckgießmaschine mitsamt Sensoren an ein Edge Device anbinden. Dabei handelt es sich um ein Steuergerät mit hoher Rechenleistung, das die Sensordaten nah am Formwerkzeug erfasst und an unsere Datenplattform anbindet. Im späteren Verlauf des Projektes kann außerdem über dieses Edge Device eine Gießprozessregelung stattfinden.

Steigerung der Interpretierbarkeit von Modellen zur Qualitätsprognose

Die Druckgussindustrie ist dafür ausgelegt, Bauteile in großen Serien zu fertigen. Das Formwerkzeug wiederum wird jedoch häufig nur als Einzelteil oder in einer Kleinstserie produziert, da es je nach Beanspruchung und Auslegung für mehrere Zehntausend Bauteile wiederverwendet werden kann. Aufgrund der hohen Rohteilkosten sind Fehler bei der Fertigung des Werkzeuges unbedingt zu vermeiden. Mit einem digitalen Zwilling kann der spanende Herstellungsprozess virtuell abgebildet werden. Im Zusammenspiel mit Machine Learning (ML) und Daten vergangener Produktionsabläufe ist es möglich, potenzielle Fehlerquellen schon vor der Fertigung zu erkennen. Hierdurch kann kostenintensiver Ausschuss in der Fertigung vermieden werden.

Machine Learning kann zur Erzeugung sogenannter Surrogatmodelle eingesetzt werden: Modelle, die mit Daten aus der Prozesssimulation und empirischen Qualitätsdaten trainiert werden, um die Qualität (z. B. Formabweichungen oder Oberflächengüte) von weiteren Gießformen vor der Herstellung vorherzusagen. Diese Modelle können auch für wechselnde Geometrien, wie sie im Formenbau üblich sind, Prognosen tätigen. Bei den meisten Modellen ist allerdings nicht ersichtlich, wie hoch die Stichproben von den zu erwarteten Ergebnissen abweichen werden, da diese für unterschiedliche Eingriffsbedingungen innerhalb des gleichen Bauteils stark variieren kann. Deshalb entwickelten die Wissenschaftler*innen eine Methode, die in Abhängigkeit der Datenlage und der zugrundeliegenden Varianz ein Konfidenzintervall für neue Prognosen ausgibt. Ein Konfidenzintervall ist ein Maß dafür, wie sicher bzw. unsicher eine Schätzung eintritt – in diesem Fall die prognostizierte Formabweichung. Das bedeutet, die Methode gibt Aufschluss darüber, mit welcher Wahrscheinlichkeit eine bestimmte Abweichung der geplanten Form eintritt, je nachdem welche Einstellung vor dem Fertigungsprozess vorgenommen werden (z. B. Schnitttiefe, Schnittgeschwindigkeit, Zeitspanvolumen). Diese entwickelte Methode liefert einen Beitrag zur Erklärbarkeit von Modellen, die mittels Machine Learning erstellt wurden, da es den Nutzern Eintrittswahrscheinlichkeiten für Qualitätsabweichungen ausgibt.

Sobald das Formwerkzeug gefertigt wurde, erfolgt die Qualitätssicherung. Zumeist werden alle geforderten Qualitätsmerkmale des Werkzeuges vollständig geprüft. Effizienter ist es, gezielt nur diejenigen Merkmale zu prüfen, für die die Prognosemodelle eine Abweichung der Norm vorhersagten. Neben den Formabweichungen ist die Oberflächenbeschaffenheit der Werkzeugformen eine der wichtigsten Qualitätsmerkmale und bestimmt die Notwendigkeit von Nacharbeiten, welche zu erhöhten Produktionskosten führen. Die Wissenschaftler*innen verfolgen bereits erste Ansätze, inwiefern mit automatisierten Methoden die Oberflächengüte neuer Werkzeugformen mithilfe von Prozessdaten vorhergesagt werden kann. Damit soll die Qualitätssicherung und eventuelle Nacharbeit vereinfacht werden.

Augmented Reality kann dafür genutzt werden, die prognostizierten Qualitätsabweichungen am Bauteil zu visualisieren, um sie im Sinne der Qualitätssicherung zu überprüfen. Diese Ansätze werden wir weiter ausbauen. Außerdem werden wir die Erklärbarkeit datengetriebener Modelle näher untersuchen und unsere Ergebnisse in die Datenplattform des Zukunftslabors einbinden. Damit stellen wir die durchgehende digitale Prozesskette sicher.

Automatisierte Machine Learning Tools in der Produktion

Die Gießform des Zukunftslabors kann dazu verwendet werden, die beschriebenen Strukturbauteile in hoher Stückzahl zu fertigen. Aufträge von Kund*innen werden geplant, sodass die Produktionsmaschinen möglichst effizient ausgelastet, die Durchlaufzeiten der Produktionsaufträge möglichst gering und die Bestände möglichst niedrig gehalten werden. Bei der Untersuchung des Potentials von ML zur Unterstützung der Produktionsplanung und -steuerung (PPS) zeigten die Wissenschaftler*innen auf, dass in den betrachteten Industrieanwendungen eine umfangreiche Bewertung bisher ausblieb. 80 % der 45 identifizierten wissenschaftlichen Veröffentlichungen analysierten nicht die Auswirkung auf die jeweiligen Geschäftsziele. Ferner fehlt es bei verschiedenen Aufgaben der PPS an ML-Anwendungen unter Verwendung von realen Daten. Zu der Produktionsplanung gehört auch die Absatzprognose: Die Unternehmen ermitteln, welche Produkte wann und in welcher Menge voraussichtlich nachgefragt werden. Eine Prognose ist von Bedeutung, wenn produktionsrelevante Vorgänge (z.B. Beschaffung von Rohstoffen, Fertigung des Produktes) zeitlich länger als der gewünschte Kundenliefertermin brauchen oder kundenanonym gefertigt wird.

Die Wissenschaftler*innen des Zukunftslabors Produktion analysieren, inwiefern Machine Learning bei der Absatzprognose eingesetzt werden kann. Mit ML-Methoden lassen sich zahlreiche mögliche Einflussfaktoren automatisiert bei der Prognosebildung berücksichtigen und können somit eine effiziente Möglichkeit zur Erhöhung der Prognosegüte darstellen. Aktuell erfolgt die Prognose in der Praxis häufig mit Zeitserienmodellen (z.B. ARIMA, exponentielle Glättung), bei denen die Prognose ausschließlich auf dem historischen Absatz beruht. Diese Verfahren stoßen jedoch zunehmend an ihre Grenzen: Zum einen sorgen die kürzer werdenden Produktlebenszyklen für kürzere Datenhistorien. Zum anderen gibt es bei sporadisch nachgefragten Produkten zu wenige Daten. Zusätzlich erzeugen Unsicherheiten am Markt (z. B. durch die Corona-Pandemie) den Bedarf, weitere beschreibende Faktoren in der Prognose zu berücksichtigen. Mittels ML-Methoden lässt sich dieser Umstand besser berücksichtigen. Kleine und mittelständische Unternehmen (KMU) verfügen jedoch nicht immer über die notwendigen Kenntnisse zum Umgang mit ML-Methoden. Aus diesem Grund erforschen die Wissenschaftler*innen den Einsatz automatisierter Machine Learning Tools (AutoML-Tools), die die Unternehmen nicht selbst programmieren müssen. Die Erkenntnisse sollen in die Datenplattform des Zukunftslabors überführt werden, damit neben den prozessbezogenen Daten der Fertigung auch eine Schnittstelle zu bestehenden Systemen der Produktionsplanung und -steuerung in die digitale Prozesskette integriert werden kann.

Darüber hinaus führten die Wissenschaftler*innen Experteninterviews mit 30 Produktionsunternehmen durch, um den Status Quo zum Einsatz von Künstlicher Intelligenz (KI) in der Produktion zu erheben. Diese Unternehmen verfügen alle über eine eigene Fertigung, z. B. aus den Bereichen Luft- und Raumfahrt oder Maschinen- und Anlagenbau. Die Auswertung der Interviews ergab, dass die Mehrheit der produzierenden Unternehmen bisher noch keine KI in der Arbeitsvorbereitung sowie zur Prozess- und Zustandsüberwachung einsetzen.

Die Ursachen, weshalb die Unternehmen noch keine KI nutzen, sind ganz unterschiedlich: Zum einen ist vielen Betrieben noch nicht klar, welches Potenzial KI für die Produktion hat. Zum anderen werden oftmals ältere Maschinen eingesetzt, bei denen die Prozessdaten nicht so einfach akquiriert werden können. Größere Unternehmen können sich hierfür Mitarbeiter*innen leisten, die entsprechende Schnittstellen entwickeln oder ein Retro-Fit durchführen, um Daten aus der Maschinensteuerung oder externer Sensoren zu akquirieren. Dies ist mit zusätzlichen Kosten verbunden. Kleinere Betriebe haben dafür keine Ressourcen. Darüber hinaus stellt es ein Problem dar, die Daten unterschiedlicher Maschinen zusammenzuführen, zu speichern und auszuwerten. Dabei spielen auch die Rückverfolgbarkeit von Bauteilen und die Verknüpfung mit den Prozessdaten eine wichtige Rolle

Im weiteren Verlauf werden die Wissenschaftler*innen einen Leitfaden für KMU erstellen und aufzeigen, welche Rahmenbedingungen für den Einsatz von KI in der Fertigung erforderlich sind (Voraussetzungen, Kosten-Nutzen-Rechnung, etc.). Der Leitfaden wird dies anhand verschiedener Szenarien aufzeigen (z. B. in Bezug auf Einzel- oder Serienfertigung).

Prototyp einer Datenplattform

Die Wirtschaftlichkeit der Produktion kann erhöht werden, wenn Daten entlang der Prozesskette ausgetauscht und analysiert werden – sowohl standort- als auch unternehmensübergreifend. Hierfür sind eine entsprechende Dateninfrastruktur und ein sicherer Datenaustausch erforderlich. Eine zentrale Herausforderung besteht darin, dass Unternehmen in den meisten Fällen ihre Daten nicht über Ihre Unternehmensgrenze hinaus preisgeben möchten. Deshalb entwickelten die Wissenschaftler*innen einen Prototyp für eine Datenplattform, die eine verteilte Dateninfrastruktur, ohne direkte Verknüpfung der Datenquellen, ermöglicht. Das bedeutet, dass die Unternehmen ihre Daten für Analysen bereitstellen, ohne dass Dritte die Daten einsehen können. Ein Beispiel: Eine Gießerei verwendet die Druckgießanlage eines Maschinenherstellers. Bei einem Gießprozess entstehen fehlerhafte Produkte. Der Fehler kann entweder in der Druckgießanlage selbst entstanden sein oder durch Fehleinstellungen der Gießerei – die Ursache ist unklar. Die Gießerei kann nun über die Datenplattform den Fehler mitteilen. Eine Verknüpfung leitet die Fehlermeldung an den Maschinenhersteller weiter. Dort werden die Daten mithilfe analytischer Verfahren, wie beispielsweise das maschinelle Lernen, untersucht. Auf diese Weise können die Daten mehrerer am Prozess beteiligter Akteure geprüft werden, ohne dass die Beteiligten ihre Daten preisgeben müssen. In diesem Vorgang kommen Smart Connector ins Spiel, die die Daten intelligent abfragen und verteilen. Intelligent bedeutet in diesem Zusammenhang, dass der Prozess der Datenabfrage und -weitergabe nicht manuell durch Beschäftigte angestoßen werden muss, sondern automatisiert über die definierten Schnittstellen geschieht.

Die erforderliche Datenplattform konnten die Wissenschaftler*innen bereits erfolgreich aufsetzen. Anhand von Beispieldatensätzen zweier Praxispartner testeten sie die Funktionsfähigkeit der Datenplattform. Um die Beispieldatensätze (bestehend aus Excel- und Word-Dateien, handschriftlichen Notizen und E-Mail-Nachrichten) nutzen zu können, brachten die Wissenschaftler*innen diese zunächst in ein einheitliches Format. Zukünftig sollen Algorithmen prüfen, wie wahrscheinlich gewisse Fehler auftreten werden, um sie zukünftig zu vermeiden. An dieser intelligenten Datenanalyse (sogenannte Smart Services) werden die Wissenschaftler*innen im kommenden Jahr arbeiten.

Die Datenplattform soll vor unberechtigten Zugriffen geschützt werden. Demnach müssen sowohl die Schnittstellen als auch die zugrundeliegende Architektur der Datenplattform Standards der IT-Sicherheit entsprechen. Deswegen überprüften die Wissenschaftler*innen gängige Datenplattformen auf die IT-Sicherheitsaspekte, die sie im vorigen Jahr als essenziell identifizierten (Vertraulichkeit, Integrität, Verfügbarkeit, Authentizität, Nichtabstreitbarkeit). Ergebnis: Die überprüften Plattformen bieten viele Aspekte, die aus der Perspektive der IT-Sicherheit erforderlich sind, aber keine Plattform umfasst alle Aspekte. Abhängig vom Anwendungsfall muss eine geeignete Dateninfrastruktur ausgewählt und dazu entsprechende IT-Sicherheitskonzepte erstellt werden. Beispielsweise muss bei sensiblen Datensätzen die Vertraulichkeit gewahrt werden, um Firmengeheimnisse zu schützen, während bei weniger sensiblen Datensätzen die Verfügbarkeit priorisiert werden könnte, um den Betrieb zu gewährleisten. Im nächsten Schritt werden die Wissenschaftler*innen ein Konzept entwickeln, wie die Erkenntnisse zur IT-Sicherheit in die Workflows der Datenplattform integriert werden können. Zu den Workflows zählt z. B. die Daten der Druckgießmaschinen zu gewinnen und in die Plattform einzuspeisen, verschiedene Kommunikationsprotokolle der unterschiedlichen Anlagen zu kombinieren oder Sicherheitszertifikate auszutauschen.

Darüber hinaus analysierten wir, welche juristischen Fragestellung in Bezug auf die Datensicherheit innerhalb der Produktion relevant sind. Dazu zählen Dateneigentum, Datenschutz und vertragliche Situation der Beteiligten – etwa (Kund*innen, Werkzeugbau, Gießerei). In einem Konzeptpapier stellten wir die Datenflüsse und die beteiligten Akteure dar. Dieses leiteten wir an einen juristischen Praxispartner weiter, der die daraus resultierenden rechtlichen Anforderungen ableiten wird, z. B. welche Verträge geschlossen werden müssen.